„Superhuman perception“: Neue Sensor-Konzepte für das Automatisierte Fahren

Sensorik und maschinelle Wahrnehmung sind bedeutende Forschungsfelder für das Autonome Fahren und die Robotik. In der Forschung wird imitiert, wie der Mensch seine Umgebung wahrnimmt – insbesondere mit visuellen Merkmalen. Die Forscher wollen aber darüber hinausgehen und eine Art „übermenschliche Wahrnehmung“ erreichen – für die Navigation in Umgebungen, die sich Maschinen mit Menschen teilen. Die dafür benötigte Technologie kombiniert menschliche Wahrnehmungsstrategien und nutzt zusätzliche Sensortechnologien wie RADAR oder LiDAR (light detection and ranging).

Maschinen bewegen sich unter Menschen

Wenn ein Mensch sich in einer Umgebung bewegt, orientiert er sich mithilfe seiner räumlich-visuellen Fähigkeiten und entscheidet dann, wohin er geht. Was befindet sich in meinem Umfeld? In welche Richtung bewegt es sich? Mit welcher Geschwindigkeit?

Computer Vision nutzt die Ergebnisse aus drei wesentlichen Forschungsfeldern, um diese Umfelderfassung zu realisieren:

- Modellbasierte Multiview-Szenenanalyse oder klassische Bildanalyse

- Daten-getriebene maschinelle Lernverfahren / „Deep Learning“

- Systeme, die Algorithmen aus diesen beiden Bereichen kombinieren

Zurzeit werden neue Videosensoren entwickelt, die Kamerasysteme mit hoher Auflösung und hohem Dynamikbereich ermöglichen und zusätzliche Informationen wie nahes Infrarot (NIR), räumliche Tiefe oder Polarisation liefern. Die multi-modalen Daten dieser Sensoren fließen in Algorithmen zur Umfeldwahrnehmung ein, welche auf „Deep Learning“-Systemen basieren.

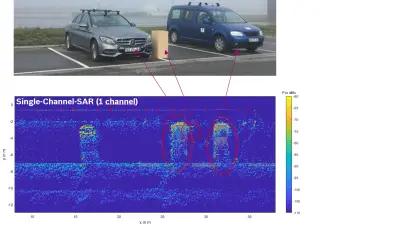

Innovative Techniken wie Synthetic Aperture Radar (SAR) verbessern die heute in Fahrzeugen eingesetzten Radarsensoren noch weiter. Wir nutzen diese zusammen mit neuen digitalen Modulationsverfahren, um mittels eines komplementären physikalischen Prinzips eine „übermenschliche“ Umfelderfassung zu erzielen. So lassen sich Radarnetzwerke realisieren, die eine 360-Grad-Sichtfeldabdeckung mit hoher Auflösung und Genauigkeit in Bezug auf Reichweite, Geschwindigkeit und Winkel ermöglichen – ein Meilenstein auf dem Weg hin zu Systemen mit „übermenschlicher Wahrnehmung“.

Optimierung von Sensoren im Kraftfahrzeug

Simulationen sind ein unverzichtbarer Bestandteil der Entwicklungsarbeit. Mit ihnen lassen sich Video- und Radarsensorsysteme in der laufenden Entwicklung optimieren und autonome Fahrsysteme entwicklungsbegleitend weiter validieren. Im Rahmen unserer Forschungsaktivitäten arbeiten wir an der automatischen Generierung von Trainings- und Validierungsdaten durch Simulation und Bildsynthese seltener Fahrsituationen. Diese Methode liefert mehr Vertrauen und Effizienz bei der Lösung von Problemen der Umfelderfassung in realen Szenarien.

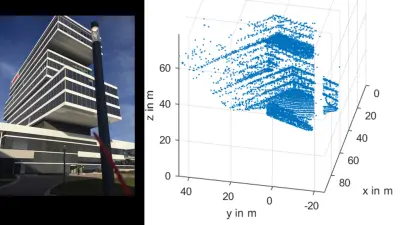

Unsere neuartigen LiDAR-Konzepte machen kostengünstige Sensoren mit großer Reichweite und hoher Auflösung möglich. Ziel unserer Arbeit ist es, auf unserem Testgelände einen Machbarkeitsnachweis zu führen und das Konzept dann zur Industrialisierung in unsere Geschäftseinheit zu überführen.

Auswirkungen auf die Produkte von Bosch

Videokamera-Produkte wie die dritte Generation der Multifunktionskamera Gen. 3 von Bosch überzeugen durch hohe Zuverlässigkeit in realen Fahrszenarien. Bei ihrer Entwicklung orientieren wir uns am Systemgedanken und berücksichtigen bereits in der Algorithmen-Forschungsphase die Produktanforderungen sowie die Umsetzung der Algorithmen als HW-IP-Blöcke auf der eingebetteten Recheneinheit der Kamera. Das unterscheidet die Computer-Vision-Forschung von Bosch von rein akademischen Forschungseinrichtungen.