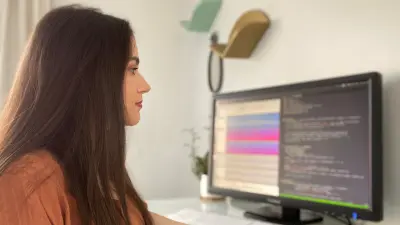

Dr. Shabnam Ghaffarzadegan

Senior Research Scientist in künstlicher Intelligenz, Audioanalyse

Meine Forschungsschwerpunkte liegen im Bereich Mensch-Maschine-Interaktion mit Bezug auf Audio-, Sprach- und kognitiver Verarbeitung. Meine Forschung verknüpft Audiosignalverarbeitung mit anwendungsspezifischen Lösungen des maschinellen Lernens. Genauer gesagt entwickle ich fortschrittliche Lösungen auf den Gebieten Audio-Szenen-Klassifizierung und Audio-Szenen-Detektion. Ziel meiner Arbeit ist es, Maschinen ein menschenähnliches Wissen und Verständnis über Ton und Sprache zu verleihen, wie sie in der Umgebung vorkommen. Die Ergebnisse meiner Arbeit werden verwendet, um die maschinelle Intelligenz zu verbessern und alternative Mensch-Maschine-Interaktionen bereitzustellen.

Erzählen Sie doch mal: was fasziniert Sie an der Forschung?

Die Forschung ermöglicht es mir, das Unbekannte zu entdecken und immer wieder Neues zu lernen. Jedes Projekt zeigt neue Perspektiven auf und bietet neue Herausforderungen auf meinem Gebiet. Ich finde es auch sehr wertvoll, aus Fehlern zu lernen und Erfahrungen daraus ableiten zu können.

Was macht die Forschung bei Bosch besonders?

Am wichtigsten für mich ist es, dass ich mit Leidenschaft forschen kann und gleichzeitig einen direkten Einfluss auf Produkte und das alltägliche Leben habe. Dass meine Ideen nicht nur auf dem Papier existieren, sondern eine echte Wirkung zeigen, bedeutet mir viel. Außerdem ist die Zusammenarbeit in multidisziplinären Teams bei Bosch sehr spannend. Dadurch fließen in jedes Projekt verschiedene Perspektiven und Erkenntnisse aus den unterschiedlichsten Bereichen ein. Als multikulturelles Unternehmen bietet Bosch uns außerdem die Möglichkeit, die Bedürfnisse von Menschen weltweit und ihre Akzeptanz von neuen Technologien zu verstehen. Mit diesen Informationen können wir unsere Produkte so anpassen, dass sie überall auf der Welt nützlich sind.

Woran forschen Sie bei Bosch?

Meine Forschung bei Bosch beschäftigt sich damit, anwendungsspezifische Audio- und Sprachtechnologien wirksam für KI-Konzepte einzusetzen, um das „Smart Ear“ für Maschinen zu entwickeln. Ich integriere die Fähigkeit zur Audiowahrnehmung in KI-Systeme, damit diese ihre Umwelt verstehen und sich besser darin zurechtfinden können.

Was sind die größten wissenschaftlichen Herausforderungen in Ihrem Forschungsfeld?

Auf dem Gebiet der Audioanalyse gibt es zahlreiche Herausforderungen. Das sind zum Beispiel:

1) Große Abweichungen innerhalb jeder Audiokategorie und ihres Kontexts, wie Hardware, Störgeräusche und akustische Umgebung. Der Einsatz von verschiedenen Mikrofonen zur Klangaufnahme, ob auf einer Party, in einem ruhigen Haus oder auf der Straße, in kleinen Räumen oder Konferenzsälen, bringt viele Herausforderungen für unsere Systeme mit sich. Wir wollen Systeme entwickeln, die unabhängig von den Umwelt- und Kontextvariationen zuverlässig funktionieren.

2) Unbegrenztes Audiovokabular in der realen Welt, was es unmöglich macht, den klanglichen Umfang einer bestimmten Aufgabe vorherzusagen. Anders als gesprochene Sprache, die eine begrenzte Menge von Alphabeten nutzt, sind die Variationen von Umweltgeräuschen unbegrenzt. Man denke nur einmal an all die verschiedenen Geräusche, die man tagtäglich hört. Es ist daher unmöglich, einem KI-System alle möglichen Töne auf der Welt beizubringen. Wir brauchen eine klügere KI, die weiß, wenn sie etwas nicht weiß.

3) Eingeschränkte Verfügbarkeit von kommentierten Daten, die aufgrund des unbegrenzten Vokabulars und der endlosen kontextuellen Variationen essentiell für Deep-Learning-Lösungen sind.

4) Den Schutz der Daten von Nutzerinnen und Nutzern unserer Systeme. Als Forschende müssen wir deren Datenschutz sicherstellen, das Risiko von schädlichen Attacken auf unsere KI-Systeme reduzieren und transparent kommunizieren, wie wir mit den Daten umgehen.

Wie werden Ihre Forschungsergebnisse zu „Technik fürs Leben“?

Effektive Audiowahrnehmung und Aspekte wie visuelle Fähigkeiten und die Verarbeitung natürlicher Sprache lassen die Smart-Life-Technologie von morgen Wirklichkeit werden. So kann unsere Technologie beispielsweise als Sicherheitssystem verwendet werden, um zerbrechendes Glas, einen Rauchmelder, ein schreiendes Baby oder einen bellenden Hund zu erkennen und den Nutzenden zu warnen. Sie kann einem vernetzten Lautsprecher („Smart Speaker“) außerdem beibringen, einen Menschen nicht zu unterbrechen, wenn er spricht. Auch ist die Technologie in der Lage, weitere laute Geräusche aus der Umgebung wahrzunehmen. Schließlich kann die Audiowahrnehmung auch Fahrzeuge befähigen, ihre Umgebung zu verstehen, dass z. B. vorbeifahrende Polizeiwagen/Krankenwagen im Einsatz erkannt werden, um entsprechende Reaktionen auszulösen.

Lebenslauf

2013-2016

EE-Doktorand, automatische Spracherkennung, Mensch-Maschine-Systeme, Universität Texas in Dallas, Richardson (USA)

2015

Forschungspraktikant, automatisierte Auswertung von spontanen, nicht-muttersprachlichen Äußerungen, Educational Testing Service (ETS), Princeton (USA)

2009-2012

Master of Science EE, blinde Separation und Lokalisation von Audioquellen, Technische Universität Amirkabir (Iran)

Ausgewählte Publikationen

Y Sun et al. (2020)

- Yiwei Sun, Shabnam Ghaffarzadegan

- 2020 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP)

A Salekin et al. (2019)

- Asif Salekin, Shabnam Ghaffarzadegan, Zhe Feng, John Stankovic

B Kim et al. (2019)

- Bongjun Kim, Shabnam Ghaffarzadegan

- 2019 27th European Signal Processing Conference (EUSIPCO)

S Ghaffarzadegan (2018)

- Shabnam Ghaffarzadegan

- Proc AAAI Wrkshp Artificial Intelligence Applied to Assistive Technologies and Smart Environments

Ihr Kontakt zu mir

Dr. Shabnam Ghaffarzadegan

Senior Research Scientist in künstlicher Intelligenz, Audioanalyse